次世代コンピュータの中核となる

新発想のチップを日本企業と共に創る

2016.07.29

人工知能が、メディアで話題に上ることが多くなった。消え去る職業は何かで一喜一憂し、技術面では、深層学習(ディープラーニング)のアルゴリズム開発など、新機軸のソフトウェア技術に注目が集まっている。誕生からちょうど70年を迎えたコンピュータは、大きく変わろうとしているのだ。それは、ソフトの話だけではない。次世代のコンピュータの中核に置かれる、新たな半導体チップが今、かつて日本の半導体開発の拠点が集中していたJR南武線沿線で研究開発されている。人間の脳のように経験から学び、相関関係を見つけ、仮説を立てる「コグニティブ・コンピューティング」の中核技術"ニューロモーフィック・デバイス"を開発する日本アイ・ビー・エム 東京基礎研究所 サイエンス&テクノロジー 部長 新川崎事業所長の山道 新太郎氏に、その意義と今後の方向性について伺った。

──新しいコンピューティングの時代を、コグニティブ・テクノロジー「Watson」で切り拓こうとしているIBMが、日本で人工知能向けチップの開発をしていることに驚きました。この分野での山道さんのお仕事についてお聞かせください。

IBM東京基礎研究所は、テキスト解析、数理科学、物理科学に基づくハードウェア技術などをベースに、社会と産業界が抱える課題をコグニティブ・コンピューティングを活用して解決するイノベーション創出に焦点を当て、幅広い研究活動を行っています。私は、その中のサイエンス&テクノロジーというハードを研究するチームを、シニアマネージャの立場で率いています。社会インフラを支えるサーバといったハードシステムの中核を担うシリコン技術、サブシステム技術といった研究のノウハウや経験を活かし、IBMのハードの発展を支えています。

2015年、当研究チームの研究テーマを、次世代のコグニティブ・コンピューティングを支えるニューロモーフィック・デバイスの研究開発に絞り、人材などを集中させました。ニューロモーフィック・デバイスとは、脳の神経回路網を参考にして、信号処理を行なう半導体チップのことです。

一般に人工知能と呼ばれる研究分野では、基礎理論から自律学習まで多様な課題に取り組んでいます。これに対し、コグニティブ・システムは、人の意思決定を支援するという明確な目的を、設計思想の中心に据えています。また、従来のコンピューティングをよりスケーラブルかつ効率化、高精度化しながら、低消費電力を追求するためには、従来とは異なる考え方が必要になります。そこで、ビッグデータからの学習、目的を持った推論、人との自然なインタラクションを高速に、かつ低消費電力で実行できるようにするために、従来の発想に捕らわれない、新しい半導体チップの研究を行っているのです。

ニューロモーフィック・デバイスの研究開発は、IBM東京基礎研究所のサイエンス&テクノロジーと、米国ニューヨーク州のIBMワトソン研究所、カリフォルニア州のIBMアルマデン研究所、スイスのIBMチューリッヒ研究所と共同で取り組む大規模な取り組みです。IBM東京基礎研究所のサイエンス&テクノロジー・チームは、高度な技術を保有してる材料メーカーと製造装置メーカーが集積する世界でも稀有な地域である日本の地の利を生かして、ニューロモーフィック・デバイス用の新しい材料や製造プロセス、回路設計の研究開発などを行っています。

ビッグデータ時代のコンピュータのあるべき姿を探求

──IBMでは、人工知能に関連する技術を、コグニティブ・コンピューティングと呼んでいますが、なぜなのでしょうか。

人類が1年間に作るデータの量は、21世紀に入って爆発的に増えています。国立情報学研究所 所長の喜連川 優氏は、その状態を「情報爆発」と呼んでいます。また、あらゆるモノがインターネットにつながりデータがさらに加速度的に増大するIoT時代が到来しようとしています。こうした時代には、データ量の増加が加速するだけではなく、そのままでは利活用できない構造化されていないデータ、時間と共に消え去っていくデータなど、扱い難いものが多く含まれてきます。そこには、人々の暮らしや社会活動の様子をありのままに映した、極めて有用な情報が潜んでおり、こうした莫大で、利活用しにくい状態にあるものの、価値の高い情報が内在しているのがビッグデータなのです。それを、どのように処理し、利用したらよいのかが、社会全体の課題になっています。

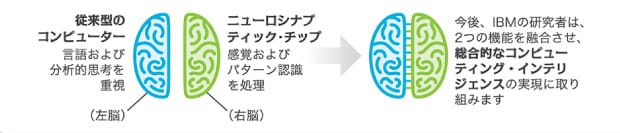

しかし、ひとつひとつのデータを、決められた手順に沿って処理していく従来のコンピュータでは、もはやビッグデータにタイムリーに、しかも低消費電力で対応することはできません。大量のデータを教材にして傾向や処理方法を自ら学習し、システムの機能や構成を変えることができる、ちょうど人間の右脳が持つような機能を、コンピュータが備える必要があるのです(図1)。

|

──現在、データセンタにビッグデータを蓄積し、強力なコンピュータによって有益な情報を抜き出す人工知能システムが実際に活用されています。人工知能の研究開発は、学習のアルゴリズムや学習教材となるデータ集めこそが重要で、半導体チップなどハードでの革新の必要性を感じていませんでした。なぜ、新しいハード技術が求められるのでしょうか。

今日のコンピュータは、1964年からほぼ世界中で使用されているフォン・ノイマン・アーキテクチャと呼ばれるアーキテクチャで稼動しています。この構造では、マイクロプロセッサとメモリが別々に存在。各電子回路がデータをやり取りするための伝送路(バス)を介し、プロセッサとメモリを接続して情報を処理する仕組みです。このバスが伝送できるデータ量には限界があるため、飽和状態になれば、おのずと性能が抑えられてしまいます。また、大量のデータを高速で処理すればするほど、既存技術ではより多くの電力を消費しなくてはならず、コンピュータの性能を今後追求して行く上で消費電力の低減が直近の課題になっています。

私たちの脳の仕組みや、人のインテリジェンスは解明されていないことが多く、私も脳を研究しているわけではないので、脳を模倣することは到底できません。しかし、たとえば20W程度の消費電力といわれている私たちのすばらしい脳の低消費電力や、マイクロプロセッサとメモリが共役し、極めて高い接続密度を実現している脳のごく一部の利点を私たちの研究目標に据えることで、ハード・アーキテクチャの新しいアプローチの発想や、消費電力の低減のための新しいアイデアを生み出すモチベーションになると考えています。私たちが考えるコグニティブ・コンピューティングを社会実装し、さまざまな用途、シーンで活用できるようにするために、このようなハード技術でのブレークスルーが必須になります。

現在のハイエンド・サーバでは、ビッグデータの情報処理を行うたびに、数十kWといった莫大な電力を消費します。ハードの中核に置かれるマイクロプロセッサは、より速く動作させようとすると、熱密度が一気に高まります。既に、これ以上高速に動作させようとすると熱で自らを破壊してしまうほどの限界に近づき、さらなる高性能化は困難になっています。このような状態では、気軽にビッグデータを活用することなど思いもよらないことになります。ビッグデータの活用で社会問題を解決するどころか、その処理自体が大きな社会問題を引き起こす原因になる可能性さえあるのです。

これまで、コンピュータの中核に置かれているマイクロプロセッサは、性能向上するにつれて、発熱が増大するため、さまざまな冷却技術が研究されてきました。一方で、基本的な構造や働きには、大きな変化がありませんでした。しかし、いよいよこれまでとは違う発想で、情報処理用のチップを作る必要が出てきたのです。