口にしなくても、思いは伝わる?

2012.3.5

|

考えていることを口に出さなくても機械が読み取り、他人に伝える。まるでテレパシーのような技術が、夢物語ではなく実現可能な目標になってきた。

2011年9月に、カリフォルニア大学バークレー校の西本伸志博士、Jack Gallant博士らのチームは、脳にある視覚皮質の活動状況をfMRI(脳の血流をMRIで視覚化する手法)を使い、患者がどのような映像を見ているのかを再現することに成功した。

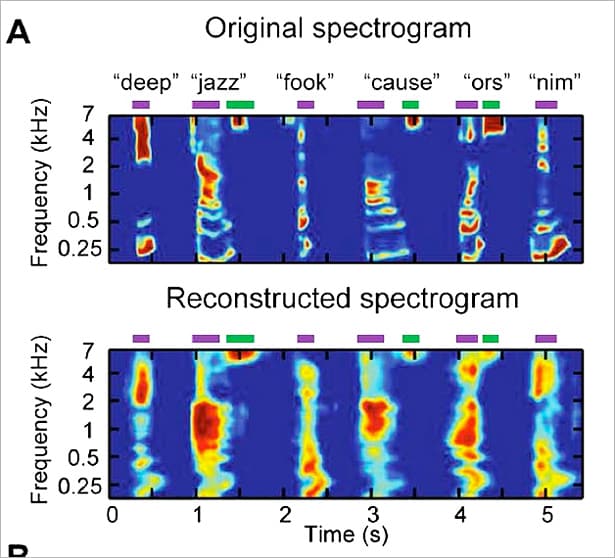

2012年1月に、同じくカリフォルニア大学バークレー校のBrian Pasley博士らは、音声刺激について同様の実験に成功した。彼らが注目したのは、脳の上側頭回(じょうそくとうかい)という領域である。この領域はたんに聴覚を処理するだけでなく、聞いた音から言語的な意味をくみ取るという高度な機能を受け持っている。

人間の脳は周波数によって反応する部位が異なるため、Brian Pasley博士らは、どの部位がどの周波数に対応するかを示すコンピューターモデルを開発。実験では、てんかんや腫瘍の治療のために手術を受ける15人の患者の脳内に電極を埋め込み、(男性と女性の両方を含む)複数の話者が単語や文を読み上げる音声を聞かせた。

患者の脳波をコンピューターモデルで解析したところ、患者が脳内にどの単語を思い浮かべたかを90%の確率で推測できた。いくつかの単語については、脳波を元に音声を再現することにも成功している。

この技術の応用ですぐに思いつくのは、話すことができなくなった患者のためのコミュニケーションツールだろう。現在のところは患者の脳内に電極を埋め込む必要があり、またあらゆる単語を認識するというレベルには達しておらず、実現にはさらなるブレークスルーが求められる。こうした課題をクリアできれば、ALS(筋萎縮性側索硬化症)などの患者にとって朗報になりそうだ。脳内に電極を埋め込む必要がなくなれば、普通の人が電子機器を操作するインターフェイスとしても応用できるかもしれない。