連載02

ブラックボックスなAIとの付き合い方

Series Report

判断時にAIが注目したポイントを特定

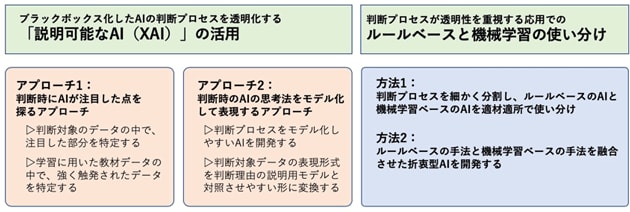

現在、研究開発されているXAIの実現方法には、大きく二つのアプローチがある(図3)。

|

1つは、AIが答えや判断を導き出す際の注目点を特定するアプローチである。判断の対象となるデータの中の、どの部分のどのような特徴に注目して予測・認識したのかを探る。現在実用化されているXAIの多くが、このアプローチを取っている。画像認識にAIを応用する例で、そのコンセプトを説明したい。まず、認識対象となる画像の一部分だけを切り取ったり、逆に一部を隠したりして、AIで認識処理させる。そして、元の画像を認識した場合と、答えや判断がどの程度変わるのか検証する。同様に、切り取り、隠す部分を変えた様々なパターンを用意して繰り返し検証し、AIの注目点をあぶり出していく。AIの注目点が分かれば、人間はその情報を基にして、判断理由を推測することができる。こうした方法は、医師が患者に病状を説明する方法に似ている。レントゲン写真を患者に見せながら、どこに、どのような所見があるのか話すようなものだ。

これに類似した別の方法もある。AIが正しい判断を下せるようになるまでには、膨大な数の教材データを使って学習する必要がある。AIの学習に用いた教材となるデータのうち、根拠を知りたい判断例では、どの教材データに強く触発されたのかを探る技術である。特定の学習データがなかったとしたら、どの程度結果が変わるのか検証し、影響が強い学習データを特定する。そして、触発された教材データを見て、判断の根拠を人間が推測する。この方法は、法律家が法的な解釈を判断する際に、過去の判例を参照して理由付けするのに似ている。

AIの注目点を探るアプローチに沿った代表的XAI技術として、「LIME(Local Interpretable Model-Agnostic Explanations)*1」と呼ばれる手法が広く利用されている。判断理由を知りたいデータを複数の部分に分解し、それぞれの部分が判断プロセスでどの程度の度合いで重要視されたのか指標で示す技術だ。しかし、実際にLIMEでAIでの画像認識を検証すると、本末転倒な判断をしていることが判明する場合もあるようだ。たとえば、「犬」と「狼」を正確に見分けていたAIの注目点を検証してみると、周囲に雪があるかどうかで見分けていたといった例があったという。これは、AIが出した答えや判断を検証することが、いかに重要であるかを示している。

AIの思考法を人間が読み下せるモデルで表現

もう一つのアプローチは、AIの思考法を人間が理解しやすいかたちにモデル化するものだ。これは、複雑な自然現象や社会現象を数式などで表現し、シミュレーションする、伝統的な科学の手法に沿ったものだと言える。モデルは、処理手順や判断の条件をルール化して作る。このアプローチは、近年、にわかに研究開発が進み始めた分野である。

ただし、AIの思考法のモデル化には、自然現象や社会現象を対象にしたモデル化と決定的に異なる点がある。AI自体が人工物なので、判断理由を理解しやすいモデルを作るために、逆に検証対象となる側のAIを改良できることだ。このため、AIの技術と判断の根拠を知るためのモデルづくりは、連動させて進めることが多い。AIを改良するだけでなく、判断対象となるデータの表現形式を、判断理由を理解するモデルと参照しやすい形に加工しておく方法もある。

このアプローチを極めて単純化した例を挙げる。例えば、プラントを動かすポンプの振動から故障の予兆を察知するAIを作ったとしよう。作り方次第では、現場から収集した振動データを解析し、いきなり故障の兆しを察知してアラートを出すAIも作れるかもしれない。しかし、これではブラックボックス化している判断プロセスの幅が広すぎて、モデル化が困難だ。しかし、AIの構造を工夫すると、少しモデル化しやすくなる。一度、異常の発見に特化したAIで振動データの中から普段とは異なる挙動を抽出。その後、別のAIで異常挙動するデータを解析し、故障に至るか否かを判断する。こうした2段階での解析を行うAIシステムならば、異常を示すデータを明示できるため、判断理由を理解するためのモデルを作り易くなる。

判断結果も、それが得られた理由の説明も、鵜呑みは禁物

しかしながら、現在のところ、あらゆるAIの判断理由をすべて説明できる万能のXAIはない。さらに、XAIから得られた説明を鵜呑みにするのは禁物だ。なぜならば、AIの注目点を特定するアプローチにしろ、思考法をモデル化するアプローチにしろ、ブラックボックス化したAIの仕組みや判断方法を完全解明して説明しているわけではないからだ。

利用するXAIで得られる説明が妥当であるかどうかを専門家が十分検証し、さらには得られる説明が納得できるものであることを確認したうえで判断する必要がある。また、AIを活用した単純な学習や推論とは別に、付加的な処理を行っているわけなので、XAIを活用する際には、システムの開発や運用に余分なコストと時間が必要になることにも留意しなければならない。

XAIの研究開発は始まったばかりだ。このため、判断プロセスの透明性を重視する応用分野では、機械学習ベースのAIよりも精度が劣ることが分かっていても、あえてルールベースのAIを活用する例がある。また、現在、世の中で活用されているAIの多くは、ルールベースのAIと機械学習ベースのAIを組み合わせて活用したり、双方の要素を融合させた折衷型AI*2を開発して利用したりすることが多い。

[ 脚注 ]

- *1

- LIME(Local Interpretable Model-Agnostic Explanations):知識抽出やデータマイニングに関する学会、「ACM SIGLDDD Conference on Knowledge Discovery and Data Mining(KDD)」の2016年開催で発表された、『“Why Should I Trust You?” Explaining the Predictions of Any Classifier』という論文で提案されたアルゴリズム。

- *2

- 一般に、判断プロセスの透明性と答えや判断の精度の間には、トレードオフの関係があることが知られている。ルールベースのAIの要素が濃くなるほど、透明性は増すが精度は落ちる。逆に、機械学習ベースの要素が濃くなれば、透明性は落ち、精度は高まる。アルゴリズムを工夫することでトレードオフの関係を高いレベルに引き上げ、応用分野の特徴に合わせて透明性と精度のバランスを調整するところが、AI開発者の腕の見せどころになっている。