連載02

ブラックボックスなAIとの付き合い方

Series Report

そして、ニューラルネットワークの規模を大きくして、データの傾向が見えにくい複雑な問題を、より高精度に解けるようにしたものがディープラーニングである。単純な構造のニューラルネットワークでは、ニューロン同士の結びつきの強弱を解析することで、画像認識の答えを得た後からどの辺に注目して判断したのか、大まかな当たりをつけることができたようだ。しかし、ニューラルネットワークの層が多層化したことで、内包している判断のルールが、さらに解読不能になった。

しかも、現在のAIは数十〜数百のパラメータを同時に勘案した複雑な条件で判断を下すことができる。人間は、何らかの判断を下すときに、問題を単純化して考えて、数種類のパラメータに着目して答えを出している。無数のパラメータにきっちりと目配りして判断するAIの判断理由を、人間が理解することはほぼ不可能である。

深刻な判断の誤りが発生しても理由が分からない

さて、AIが出した答えの根拠が分からないと、どのような不都合があるのだろうか。結論から言えば、最もAIの力を借りたい分野で、その利用を躊躇させるような不都合が生じる。

アップル(Apple)の「Siri」やマイクロソフト(Microsoft)の「Cortana」、アマゾン(Amazon)の「Alexa」など、スマートスピーカーやスマートフォンで利用できるパーソナルアシスタントには、AIによる音声認識機能が使われている。こうしたAIの認識率は随分と向上してきているが、まだまだ完全とは言えない。問い掛けても、聞き間違える場合が多々ある。しかし、パーソナルアシスタントが誤解したとしても、エンジニアでもない限り、誤解した理由を知りたいとは思わない。それほど大きな問題も、被害も生じないからだ。

ただし、AIが誤った判断を下しても大した問題が起きないと思っていた応用で、大問題が起きた例もある。たとえば、検索サービスで、画像データを基に類似画像などを検索するサービスがある。通常、画像認識ソフトが画像を誤認しても大きな問題は起きないと思いがちだ。検索結果が指定画像と異なっていても、「検索精度がよくないな」と感じる程度だろう。ところが、あるIT企業が開発した画像認識サービスが、黒人女性の顔の画像をゴリラと判断してしまい、人権上の理由から一時稼働停止に追い込まれた例がある。こうなると、サービスと運営会社の信用はガタ落ちになる。機械に欠陥があれば、その原因を究明して、対策を考えるのが常道だ。しかし、判断理由を明示しない現在のAIは、その原因の究明が困難だ。

実は、ディープラーニングには、処理のブラックボックス化と並び、「過学習」というやっかいな課題がある。たくさん学習すれば、判断の精度が高まるわけではないのだ。たとえば、先の画像認識の例は、学習データに使った写真が意図的に白人のものが多かったため、気付かないまま白人の顔を人間の顔であると学ばせてしまったことによって起きたものだ。学習すればするほど、学習データに含まれる意図しない偏りに特化した判断ルールが刷り込まれてしまう。そして、当初思っていたような画像認識とは異なる判断をするようになってしまうのだ。AIが判断理由を提示できれば、こうした誤った原因が明確になり、迅速な対処できるだろう。

AIが出した答えで、納得できるか

また、AIの応用が想定されている分野の中には、答えだけでなく、答えを出した根拠を同時に知りたいものが意外と多くある。

たとえば、AIで履歴書に書かれている内容を読み取り、多くの応募者の中から面接対象となる少数の採用候補者を絞り込む場合などがそれに該当する。応募者を絞り込むわけだから、当然、AIが不採用と判断した人も多く出てくる。不採用になった人からすれば、自分がなぜ不採用になったのか知りたいに違いない。たとえ、その会社の判断が覆ることがなくても、不採用理由には改めるべき点のヒントが含まれているからだ。ところが、AIの判断では、不採用の理由が語られることはない。客観的視点を持つAIが判断しているのだから、主観や偏見が採用基準に混じることがない安心感はあるが、理由が分からない状態に納得感が得られない人は多いだろう。そもそも、採用した会社も、採用理由が分からないと、その人をどのように生かしたらよいのかが分からない。

もっと深刻な例もある。臓器提供の登録者が亡くなった際に、適切な臓移植対象者を選ぶような場合である。最近では、症状や血液型、拒絶反応の有無など、様々な観点から最適な対象者をAIで選択する方法の採用が検討されている。AIに選ばれた患者は選ばれた理由を問うことはないが、選ばれないまま長く待ち続ける患者は、どのような基準で選ばれているのか、納得のいく説明がほしいところだろう。

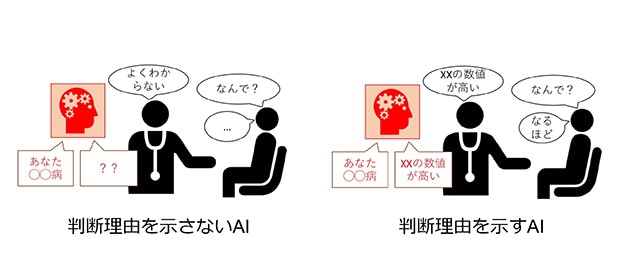

また、様々な検査の結果を統合して、病気の診断を行うAIの開発も進んでいる。多くの要因に同時に目配りできるAIは、人間よりも正確な診断や早期の診断ができる可能性がある。ただし、こうしたAIも判断理由は示さない(図5)。その診断結果を基に、患者はリスクを伴う治療に踏み切ることができるのだろうか。通常、患者は医師の論理的で分かりやすい説明を聴いた上で納得し、治療の決断をする。このため、AIが病気だと判断した際には、その妥当性の説明責任は医師に丸投げされる。その時、もしも医師が、「なんだか理由は分からないが、AIが糖尿病だと診断しています。すぐにでも治療に取り掛かりましょう」と言ったら、あなたはどうするだろうか。

|

一方、医療分野でのAIの活用例では、X線写真などを画像解析して、ベテラン医師でも見逃してしまうような僅かな病変を見つけ出すといったものもある。読影と呼ばれるこうした作業では、AIの判断の根拠が分からなくても大きな問題はない。AIが病変ありと判断したら、徹底した再検査で、医師が診断できるデータを得ることができるからだ。