連載02

ブラックボックスなAIとの付き合い方

Series Report

AIの驚くべき能力は創発性があればこそだが…

これまでの工業製品では、創発性のような設計者がコントロールできない性質を機械が存在することを想定していなかった。そのことを端的に示しているのが、工業製品のユーザーや社会に何らかの損害を出した際の責任の所在を決める法律、製造物責任法(PL法)である。

PL法では、出荷時の製品自体に欠陥があったかどうかだけが賠償責任の判断基準となる。製品を作ったメーカーが、その損害を予想できていたことを問う「予見可能性」や、その損害を回避する義務を果たしたのかを問う「結果回避義務違反」など、メーカー側の過失だけが問われる。ところが、AIを搭載した機器では、メーカーには予見可能性がないケースがほとんどだ。このため、ユーザー側から見れば、不具合を抱えて損害が発生しても、PL法によってメーカーの責任を問いにくい状況になる。

このような解説をすると、創発性は迷惑な特徴のように感じるかもしれない。しかし、創発性があるからこそ、AIが有用であると言える。複雑な環境、たとえば人とロボットが共存しているような場所で、何をするか分からない人の動きに合わせて、臨機応変に対応することができるのは、AIの創発性があればこそである。機械側から見れば、人間は、予測不可能で非合理的な行動をする存在である。創発性がないと、設計者が、あらゆるケースを想定して、動作の一から十まで指定しなければならない。これでは、開発のコストと時間が非現実的なレベルにまで増大してしまう。

人とAIが共存していくうえで、創発性は、一面では必要不可欠な性質であるが、半面で現在の社会に適合できない要因にもなる。

メーカーは、AI搭載機器の安全性をどのように保証するのか

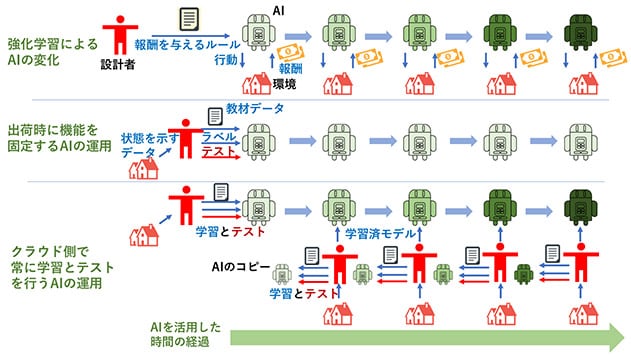

自動運転車やロボットのような人と共存しながら利用されるAI搭載機器は、少なくとも人に危害を加えないような安全性を担保して、製品を発売する必要があるだろう。しかし、創発性があるため、AI搭載機器のメーカーが、製品の機能や信頼性、安全性を保証することがとても難しい。その対策として、いくつかのAIの運用方法が考えられている。最も機能や信頼性、安全性を保証しにくい強化学習と比較しながら、運用法を説明したい(図3)。

|

まず考えられる対策は、製品の開発段階だけでAIを学習し、出荷後は学習済みのAIに一切手を加えないという方法である。この方法ならば、出荷時に様々な状況を想定したテストを行うことで、メーカー側が考える安全性を作り込むことができる。ただし、この方法では、自動運転車やロボットのAIを、利用時に遭遇した状況を盛り込みながら、より賢く育てていくことができない。

これを発展させた方法として、利用時に遭遇した状況の挙動データをネット経由でクラウド上に吸い上げ、クラウド側でAIを学習とテストを行い、安全確認後にユーザーが保有する自動車やロボットに戻す方法がある。この方法ならばAIを逐次育てながら、メーカー側での安全確保も可能になる。ただし、この運用法では、ユーザーごとの利用環境に合わせたカスタマイズやリアルタイムでの機能や性質の向上はできない。それでも、自動車メーカーやロボットメーカーは、安全を第一に考え、このような運用にとどめると思われる。

AIを利用者側で勝手に学習させなければ、何の問題もないように思えるがそうでもない。実は、機械学習ベースのAIは、通常の工業製品では当たり前のように行われているテスト自体が実施しにくいのだ。これは、AI内部での判断プロセスがブラックボックス化していることによる。一般に、AIのようなソフトウエアのテストでは、処理の手順や条件が明確に分かるソースコードを検証し、仕様通りに出来上がっていることを確認する。しかし、現在のAIでは、内部がブラックボックス化しているため、学習済みAIを仕様書と照らし合わせて検証することができない。入力に対する出力を検証するテストは実施可能だが、AIは入力がわずかに変化しただけで、出力である判断結果が大きく変わる傾向がある。このため、AI内部の機能や性質を正確に検証することは難しいようだ。ここは、新たな技術開発のテーマになっている。

ユーザー側にもAI活用の原則の遵守を求める

AI搭載機器を安全に利用するためには、メーカーの自助努力だけでは足りない。従来の機械にはない創発性を持つため、ユーザー側にも相応の利用上の注意が求められる。特に、ユーザー側がAIの学習に関与する場合に、その点を踏まえた利用指針も必要になる。AIを生活や仕事、社会のなかでフル活用する時代の到来を前にして、世界中でAI活用の指針を設けようとする動きが活発化している。

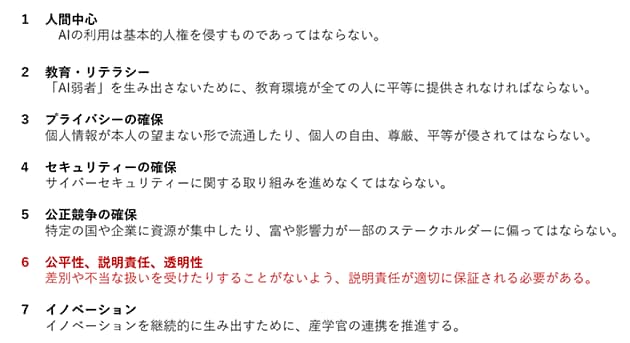

日本政府は、2018年12月に、内閣府などが分野を超えた有識者を集めて開催した「人間中心のAI社会原則検討会議」がAIの活用に関する原則案を公表(図4)。今後は、この原則に基づいて法整備を進めていくとしている。原則案は、7項目で構成している。

|

この原則案の中で注目したいのは、AIが下す判断について、AIの利用者にも説明責任を求めている点だ。たとえば、AIがブラックボックス化している以上、AIを搭載した自動運転車が暴走した際に、ロボットだけを調べても暴走した原因を説明することはできない。では、どのように説明責任を果たすのか。原因を状況証拠から推定できるようにしておくために、運転記録装置の設置の義務付け、位置情報やハンドル操作、自動運転システムの稼働状況などの記録などが求められることになる。

2019年5月には、経済協力開発機構(OECD)が、パリで開催されたOECDフォーラムにおいて、AIに関する一連の原則を発表した。原則は「地球上の人々と地球への利益」「法の支配、人権、民主主義的価値観、多様性の尊重」「透明性と責任ある情報開示」「堅牢性と安全性」「説明責任」に関する5原則で構成されている。ここでも、透明性や情報開示、説明責任がキッチリと明記されている。OECDが発表した原則は、日本政府が公表した原則案とかなり整合性の高い内容になっており、AI活用のルール作りでは日本が世界をリードしていることを印象づけている。